Respuesta: 4K: el post

En mi humilde opinión la mejora que podremos notar vendrá más por la remasterización/restauración del material de origen que por la resolución 4K "per se".

Incluso la gente que tenemos pantallas de proyección normalitas (2Mt de base a 3.70 de distancia en mi caso) no creo que notemos gan diferencia. Con respecto al usuario medio (42" o 50") sobran las palabras.

Bajo mi punto de vista si se quiere mejorar la experiencia para una mayor parte de usuarios los cambios venideros deberían ir enfocados más hacia el tratamiento del color tanto en muestras como en profundidad.

Si os apetece perder el tiempo os expongo a continuación unas ideas, tal vez equivocadas fruto de mi ignorancia, al respecto:

Gamut CIE

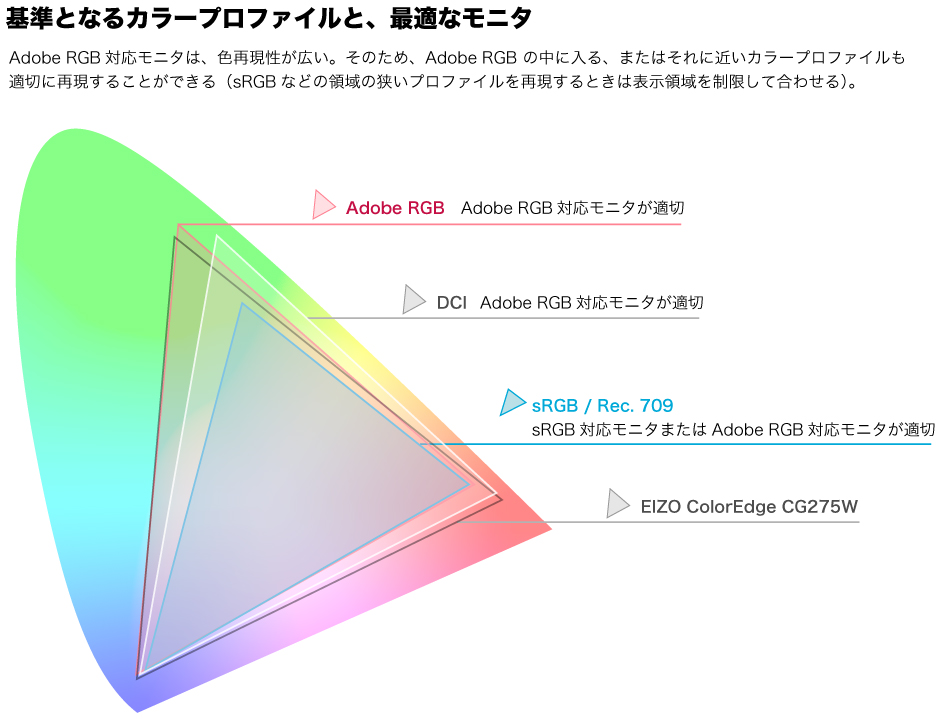

Supongo que todos lo sabemos pero no está de más recordarlo, el triángulo CIE muestra tanto los colores que es capaz de representar un dispositivo como los colores que están incluídos en una norma.

Esto se hace dibujando un triángulo cuyos vértices representan coordenadas concretas de los colores primarios rojo (R), verde (G), azul (B). En el caso del gamut de un dispositivo dichas coordenadas se obtienen a través de una sonda mientras que en el caso de las normativas vienen indicadas en la misma especificación.

Por ejemplo, podemos ver las coordenadas definidas para DCI en el apartado

3.2.1.5 Encoding Primaries (página 27) del

documento de Especificaciones para Sistema de Cine Digital (DCI) v1.2

En la siguiente imagen podemos apreciar la comparación entre el gamut de la normativa ITU-709, el de la normativa de cine digital (DCI) y el de un monitor EIZO ColorEdge:

Como se puede observar el gamut de ITU-709 es bastante más pequeño que el de DCI, esto se traduce en que la gama de colores originalmente grabada en un BD no puede reproducir fielmente la que se pueda apreciar en una proyección de cine digital.

Espacio de color

Con el fin de almacenar digitalmente la señal de color RGB ésta se codifica convirtiendo al espacio de color YCbCr ganando principalmente en tamaño de almacenamiento (mucho menor), dicho espacio de color es el usado en la especificación de Blu-Ray donde, además, se indica que los datos de color se almacenan con muestreo 4:2:0.

¿Qué significa esto de muestreo 4:2:0? Pues significa, más o menos, que por cada grupo de 4 pixels de la imagen se guarda la información de brillo/luma (Y) de los 4 mientras que la de color sólo se guardará para la mitad, esto es debido a que la naturaleza visual humana es más sensible a variaciones de brillo/luma que a variaciones de color.

Si quisiéramos ser fieles al original deberíamos muestrear 4:4:4 (se muestrea Cb y Cr a la misma frecuencia de muestreo que Y) aunque incluso un muestreo 4:2:2 (Cb y Cr a la mitad de frecuencia que Y) sería mucho mejor que el 4:2:0 que tenemos en la actualidad

tanto para BD como para DVD.

Este submuestreo es el culpable de que algunos lectores presenten el famoso CUE (Chroma Upsampling Error) dado que el muestreo de disco 4:2:0 hay que pasarlo a muestreo 4:4:4 o 4:2:2 surgiendo errores visuales en caso de hacerlo incorrectamente.

Creo que la inmensa mayoría de los dispositivos de visualización actuales soportan YCbCr con frecuencia de muestreo 4:2:2 e incluso 4:4:4.

Precisión del color

Pero no sólo tenemos el problema de los "submuestreos" indicados en el punto anterior sino que, además, la precisión con que se guarda cada muestra de color es de 8 bits, lo cual tampoco es ninguna maravilla.

Al igual que el muestreo 4:2:0 esta limitación

es la misma tanto para BD como para DVD.

Por lo que vemos en el

documento de Especificaciones para Sistema de Cine Digital (DCI) v1.2 se indica lo siguiente al respecto de la profundidad de bits para color:

3.2.1.7. Bit Depth

The bit depth for each code value for a color component shall be 12 bits. This yields 36 bits per pixel.

O sea, que en DCI utilizan una resolución de 12 bits por componente mientras que en BD utilizamos 8.

Como curiosidad: HDMI 1.3 no sólo soporta 36 bits (12 bits por componente) sino que incluso soporta 48 bits (16 bits por componente), esto es lo que llaman DeepColor.

¿Cómo afectaría al usuario final (económicamente)?

Lógicamente para llevar a cabo estos cambios sería necesario una nueva especificación de Blu-Ray lo cual implicaría

sólo el cambio de la fuente (lector de BD) dado que los dispositivos de visualización actuales soportan resolución de color de 36 bits (3 canales a 12 bits por canal) desde HDMI 1.3, YCbCr 4:4:4/YCbCr 4:2:2 y tienen un gamut físico mucho mayor que el de ITU-709.

Con el cambio de 4K que "proponen" ahora nos veremos obligados a

cambiar tanto el dispositivo de visualización (que es lo más caro de todo)

como la fuente.

Referencias

Referencias

Disculpas por el tocho.

. No sé como estará ultimamente de novedades con sus chips, porque los DLP se están quedando también descolgados, es de risa que lo que se esté empleando mayoritariamente todavía sea el DC2, algún DC3 y el DC4?... ese gran desconocido.

. No sé como estará ultimamente de novedades con sus chips, porque los DLP se están quedando también descolgados, es de risa que lo que se esté empleando mayoritariamente todavía sea el DC2, algún DC3 y el DC4?... ese gran desconocido.

pero el problema reside en que la especificación de Blu-Ray sólo permite 4:2:0 y 8 bits de precicisión.

pero el problema reside en que la especificación de Blu-Ray sólo permite 4:2:0 y 8 bits de precicisión.

.

.