El HDR para vídeo no tiene mucha relación con el HDR utilizado en fotografía.

El HDR en vídeo digamos que consiste en masterizar el contenido permitiendo niveles de brillo muy altos para mejorar el impacto (contraste) de la imagen en dispositivos compatibles, lo cual no necesariamente desvirtúa la imagen original. La imagen que se ve en los televisores y formatos actuales suele estar algo capada/reajustada respecto al máster original para adecuarse a las limitaciones de los formatos y dispositivos domésticos, y esta es una forma de asemejarlo más a un DCP proyectado en un cine.

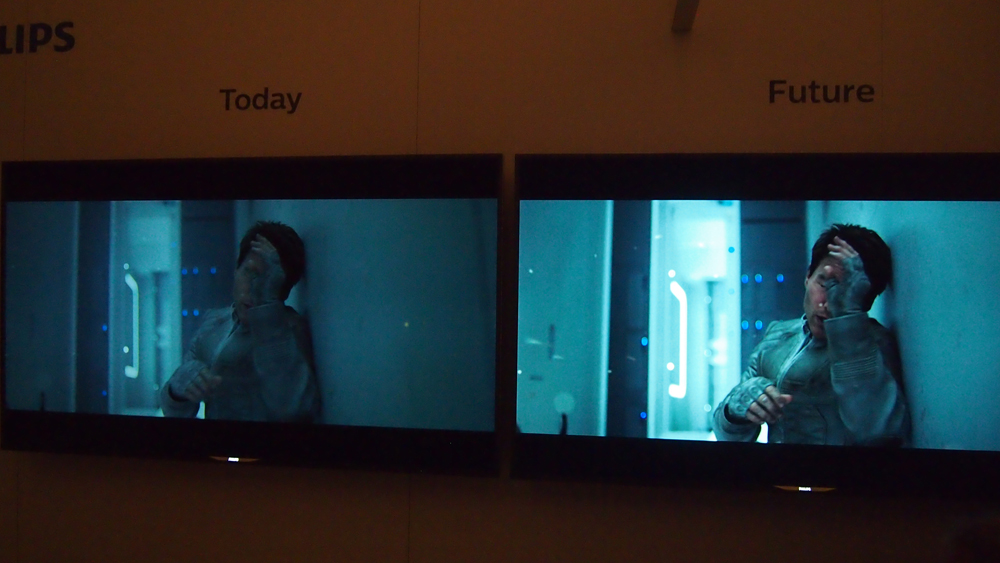

En este ejemplo se puede ver, dentro de las limitaciones de fotografiar una demo, que el HDR no altera la imagen más allá de ampliar la escala de brillo para hacerla más vibrante:

Es decir, el detalle en zonas luminosas y zonas oscuras parece el mismo así como el equilibrio general de la luz en la imagen.

Otro ejemplo con más zonas oscuras que, aunque no sea una foto muy rigurosa, permite hacerse una idea de por donde van los tiros:

Creo que aunque se trate de películas editadas en HDR, estas seguirán siendo compatibles con SDR (Standard Dynamic Range, las teles normales de toda la vida) puesto que la información HDR serán unos metadatos transferidos a la pantalla por HDMI junto a la imagen, por lo que si la tele es compatible se verá con HDR y si no lo es se verá con normalidad en SDR.

Esto puede parecer bastante trivial, pero no lo es tanto ya que si ahora te descargas cualquier vídeo HDR de internet y lo reproduces en el ordenador o en un televisor convencional te encontrarás que la imagen aparece con mucho brillo y poco contraste debido a que solo lleva información HDR que no es válida para pantallas no compatibles. O sea, que si se pone un Ultra HD Blu-ray en un televisor Full HD SDR se podrá ver la película sin problemas.

Lo cierto es que la resolución es solo uno de los puntos de mejora de este formato. Si le sumamos la superior codificación del HEVC, color de 10bit, el soporte de HDR y de espacio de color ampliado, las películas en Ultra HD Blu-ray pueden suponer un salto cualitativo importante para quienes tengan una pantalla capaz de sacarle partido, que ahora son pocos pero en 3-4 años serán bastantes.